본 포스팅은 개발 지식이 없으신 분들을 타겟하여 작성하였습니다.

참고 바랍니다.

코딩 몰라도 괜찮아요!

개발 지식이 없어도, 단계별로 따라 하기만 하면 로컬 PC에서 나만의 인공지능 모델을 실행할 수 있다면 믿으시겠나요?

이번 블로그 글에서는 프로그래밍을 전혀 모르는 분들도 쉽게 따라 할 수 있는 방법으로, Ollama와 Chatbox를 활용해 Gemma 3(4B) 모델을 설치하는 과정을 소개합니다.

복잡한 코드는 잊고, 설치만으로 AI를 경험해보세요!

한번만 따라하시면, 아래 모델들을 PC에 설치하여 돌려보실 수 있습니다.

- Google - Gemma3 / Gemma2 ...

- China - Deekseek-r1

- LG - Exaone / Exaone Deep

- Meta - Llama 3.2 / Llama 3 ...

- Mistral AI - Mistral

- Alibaba - Qwen2.5 ...

로컬에서 LLM(대규모 언어 모델)을 실행하면 웹 기반 AI 서비스와는 다른 매력을 느낄 수 있는데요.

먼저, 두 방식의 차이를 알아보고, 왜 Ollama와 Chatbox를 선택했는지 설명한 뒤 설치 방법을 안내하겠습니다.

웹 기반 LLM vs 로컬 LLM: 어떤 차이가 있을까?

LLM을 사용하는 방식은 크게 두 가지로 나뉩니다.

웹에서 제공되는 서비스(예: ChatGPT)와 로컬 PC에 설치해 사용하는 방식.

이 둘의 차이를 간단히 정리하면 아래와 같습니다.

| 구분 | 웹 기반 LLM | 로컬 LLM |

| 인터넷 연결 | 필수 ( 온라인에서만 동작 ) | 불필요 ( 오프라인 사용 가능 ) |

| 개인 정보 | 입력 데이터 서버 전송, 유출 가능성 | 데이터가 PC에만 저장, 프라이버시 보장 |

| 속도 | 서버 상태나 네트워크의 의존 | PC 성능에 따라 결정 |

| 비용 | 무료 또는 구독료 | 오픈 소스 기준 0원 |

| 사용성 | 로그인 후 사용 | 초기 설치 필요 |

개인 컴퓨터 사양에 따라 사용 가능한 모델이 달라져 품질의 차이는 날 수 밖에 없습니다.

고사양의 컴퓨터 (특히 그래픽카드)에 따라 모델 선택의 폭이 결정되므로, 저사양이라면 이런거구나 정도만 보시고 웹 기반 LLM을 추천할 수 밖에 없죠.

그렇지만 로컬 LLM을 쓰는 부분에 있어 장점은 확실합니다.

인터넷 연결 없이도 동작하며 데이터가 외부로 나가지 않아 민감한 작업에 적합하기에, 큰 기업일수록 회사만의 LLM을 만들어 사내에서만 사용하는 사례가 점차 늘어나고 있고 이에 맞춰 AI 솔루션 회사들도 많이 생겨나고 있습니다.

그런 부분을 간접적으로 경험해보고 이런거구나 정도 알아가는 정도로만 보시는게 좋지, ChatGPT처럼 고퀄리티의 답변을 기대하시면 안됩니다.

왜 Ollama와 Chatbox를 선택했나?

로컬 LLM을 설치할 수 있는 도구는 많지만, 저는 Ollama와 Chatbox를 추천합니다.

이유는 아래와 같습니다.

- 프로그래밍 지식 제로: 복잡한 코드 작성 없이 설치

- 간편한 사용성: Ollama는 모델을 쉽게 다운로드 및 실행역활, Chatbox는 채팅창처럼 편리한 인터페이스를 제공

- 무료 오픈소스: 개인이라면 비용 걱정 없이 누구나 사용 가능

코딩을 몰라도 마우스 클릭과 간단한 명령어만으로 AI를 뚝딱 실행할 수 있다는 점이 이 조합의 최대 강점입니다.

자, 그럼 설치 시작해볼까요?

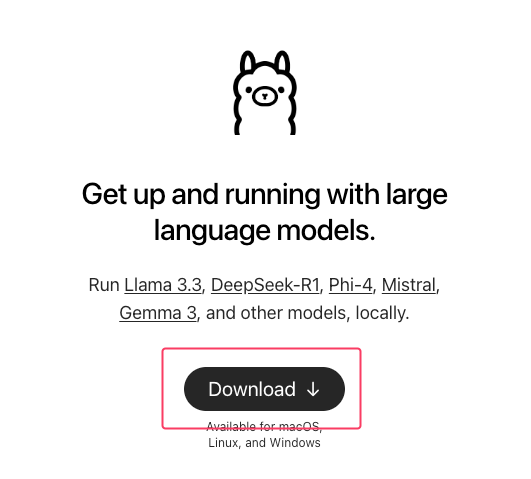

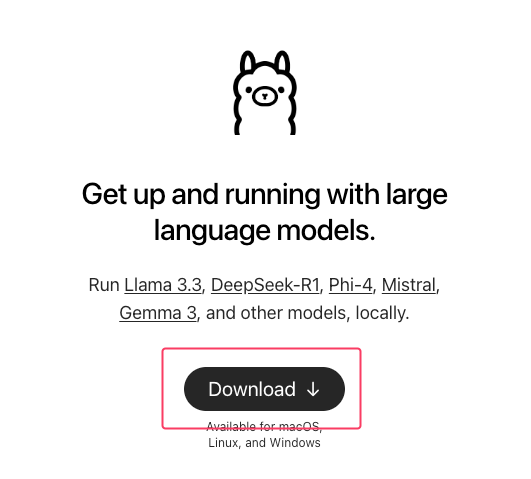

1. Ollama 설치하기

Ollama는 로컬에서 LLM을 실행하는 핵심 도구입니다.

Ollama 다운로드

- Ollama 공식 웹사이트에 접속하세요.

- 내 운영체제에 맞는 파일을 다운로드합니다

- Windows: .exe 파일

- macOS: .dmg 파일

- Linux: 터미널에 [ curl -fsSL https://ollama.com/install.sh | sh ] 입력.

- 다운로드한 파일을 더블클릭해 설치합니다.

- Ollama를 실행합니다. (실행시 tray아이콘이 표시됩니다)

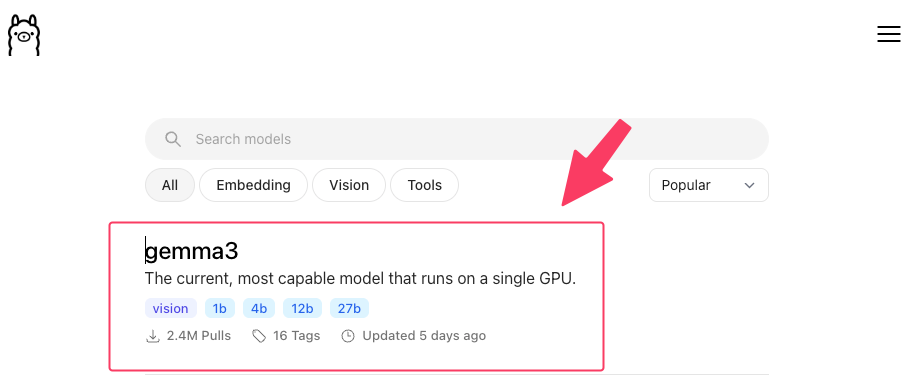

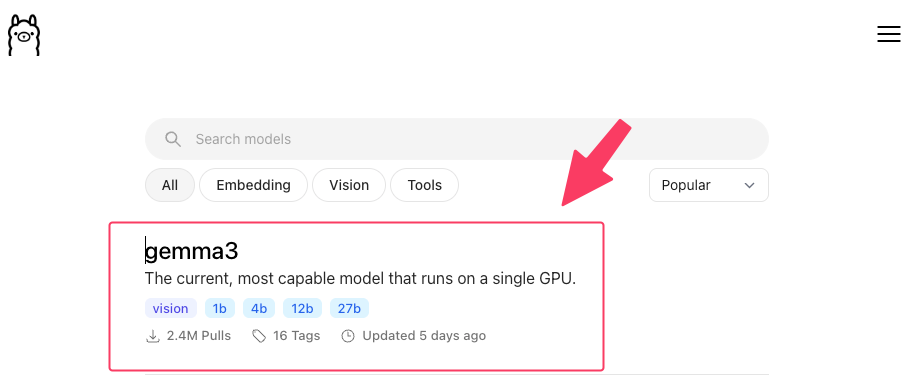

2. Gemma 3 (4B) 모델 설치하기

모델은 자유롭게 선택하여 설치하셔도 좋지만, 처음이시라면 4B짜리 gemma3 모델로 먼저 설치해보겠습니다.

1) Ollama 공식 웹사이트에서 모델 정보를 확인합니다.

https://ollama.com/search

2) gemma3를 검색하시거나 이미 보이신다면 클릭하여 페이지 내부로 들어갑니다.

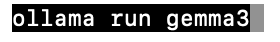

3) 왼쪽 셀렉트박스를 4b로 선택하신 후, 복사버튼을 누룹니다.

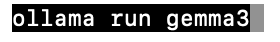

4) 터미널 ( 명령프롬프트 ) 를 실행하여 붙여넣기를 한 후 엔터를 칩니다.

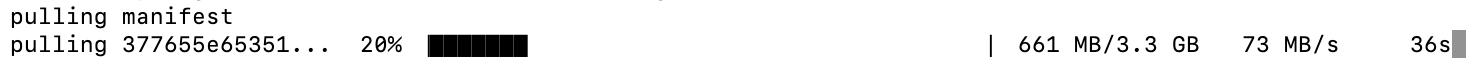

5) 다운로드가 진행되고 대기합니다.

6) 다운로드가 끝나면 바로 모델에게 질의를 할 수 있습니다만, 터미널에서 하지마시고 일단 창을 끕니다.

ollama list 라는 명령어를 사용했을 때 gemma3:latest가 보이면 성공입니다.

3. Chatbox 설치 및 연결하기

터미널 대신 예쁜 채팅창으로 대화하길 바라므로 Chatbox를 설치하겠습니다.

1) ChatBox 다운로드

- Chatbox 웹사이트에서 운영체제에 맞는 파일을 다운로드

- 설치 파일 실행하여 설치 진행

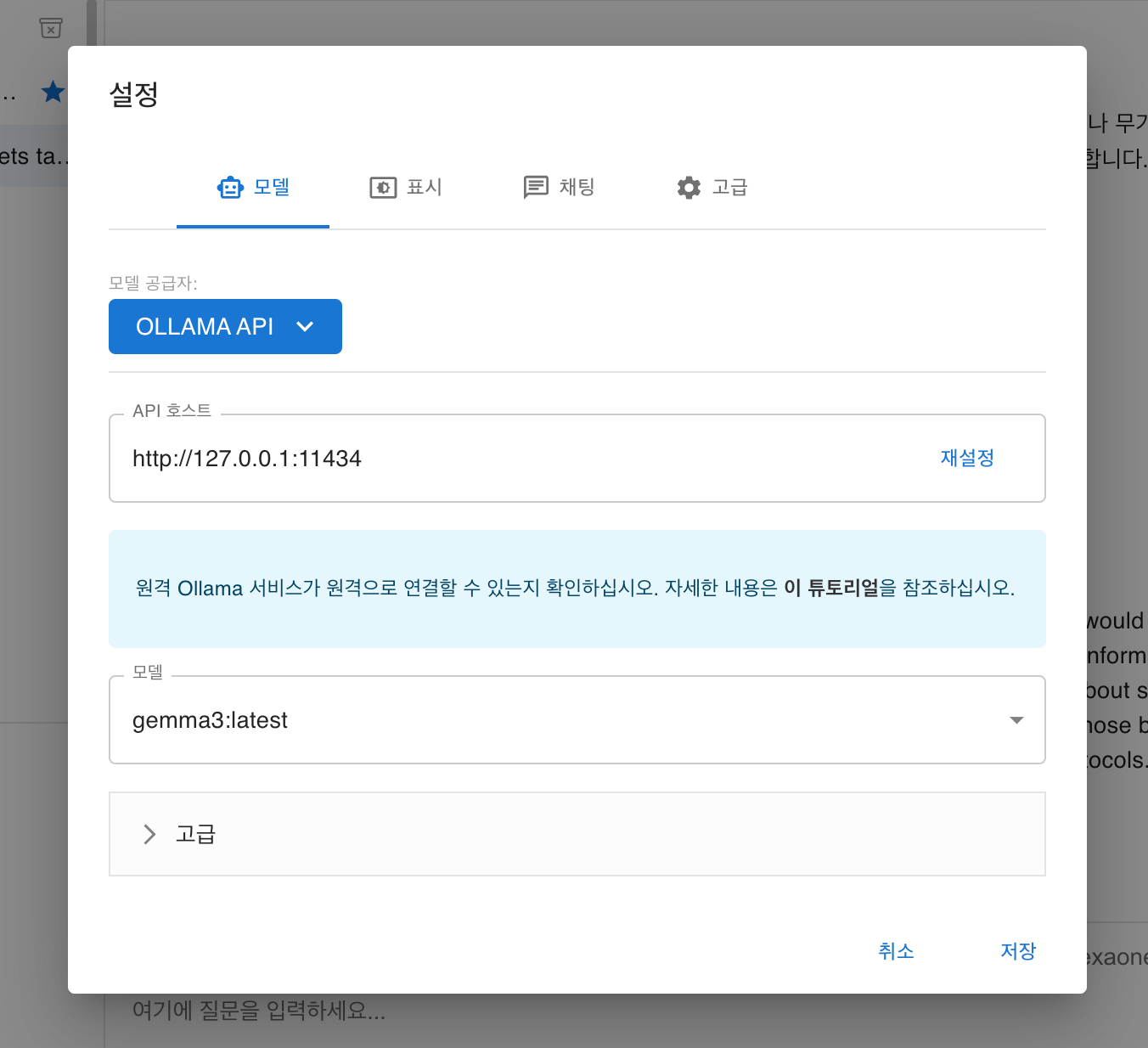

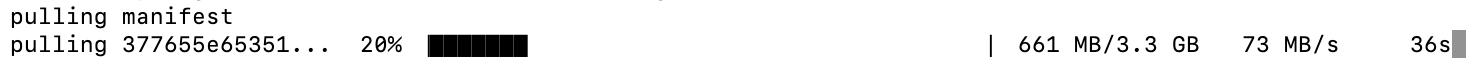

2) Ollama와 연결

ChatBox를 열고 Settings로 이동 - Settings(설정)에서 아래와 같이 설정 (또는 그림과 같이) - 저장

- 모델 공급자 : OLLAMA API

- API 호스트 : http://127.0.0.1:14434

- 모델 : gemma3:latest

4. 채팅 시도

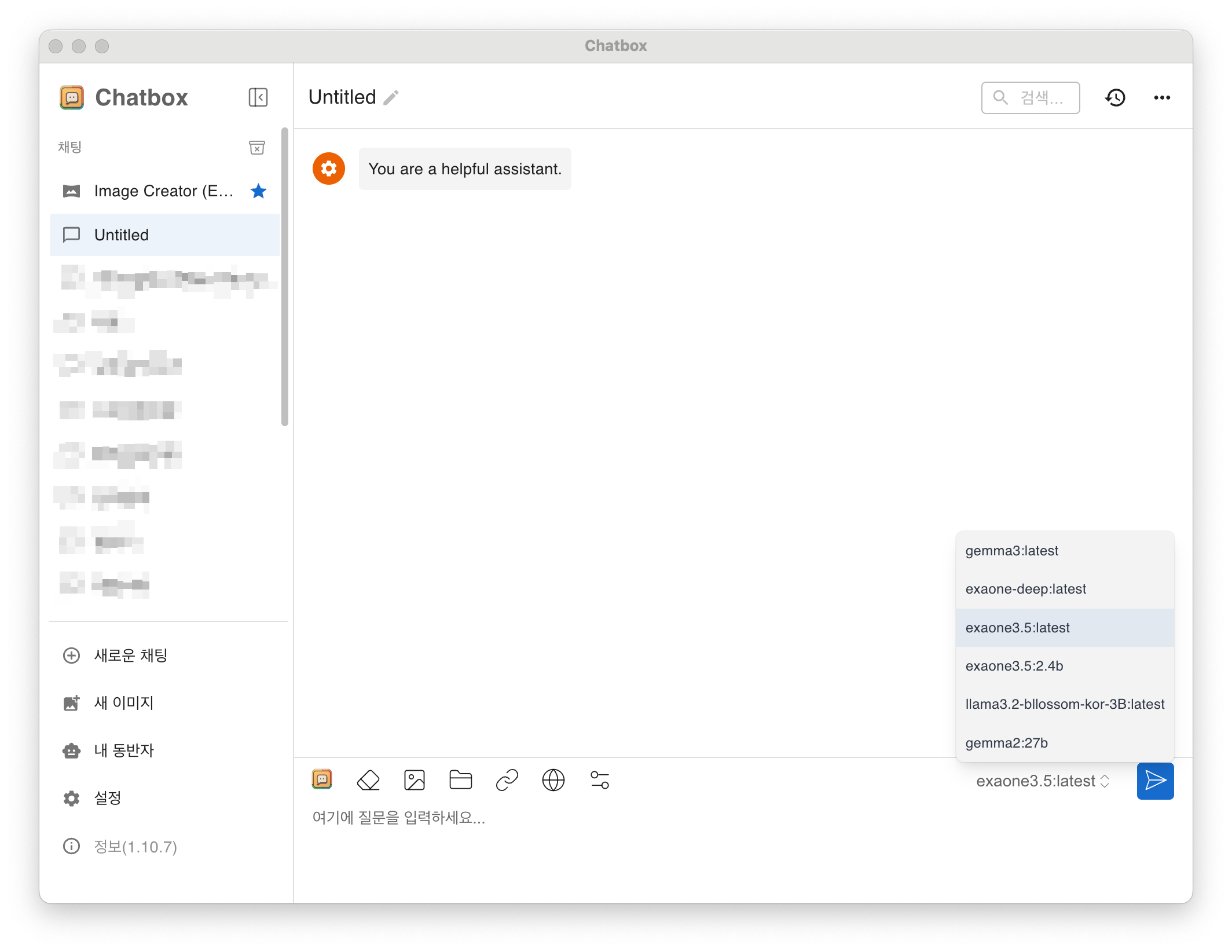

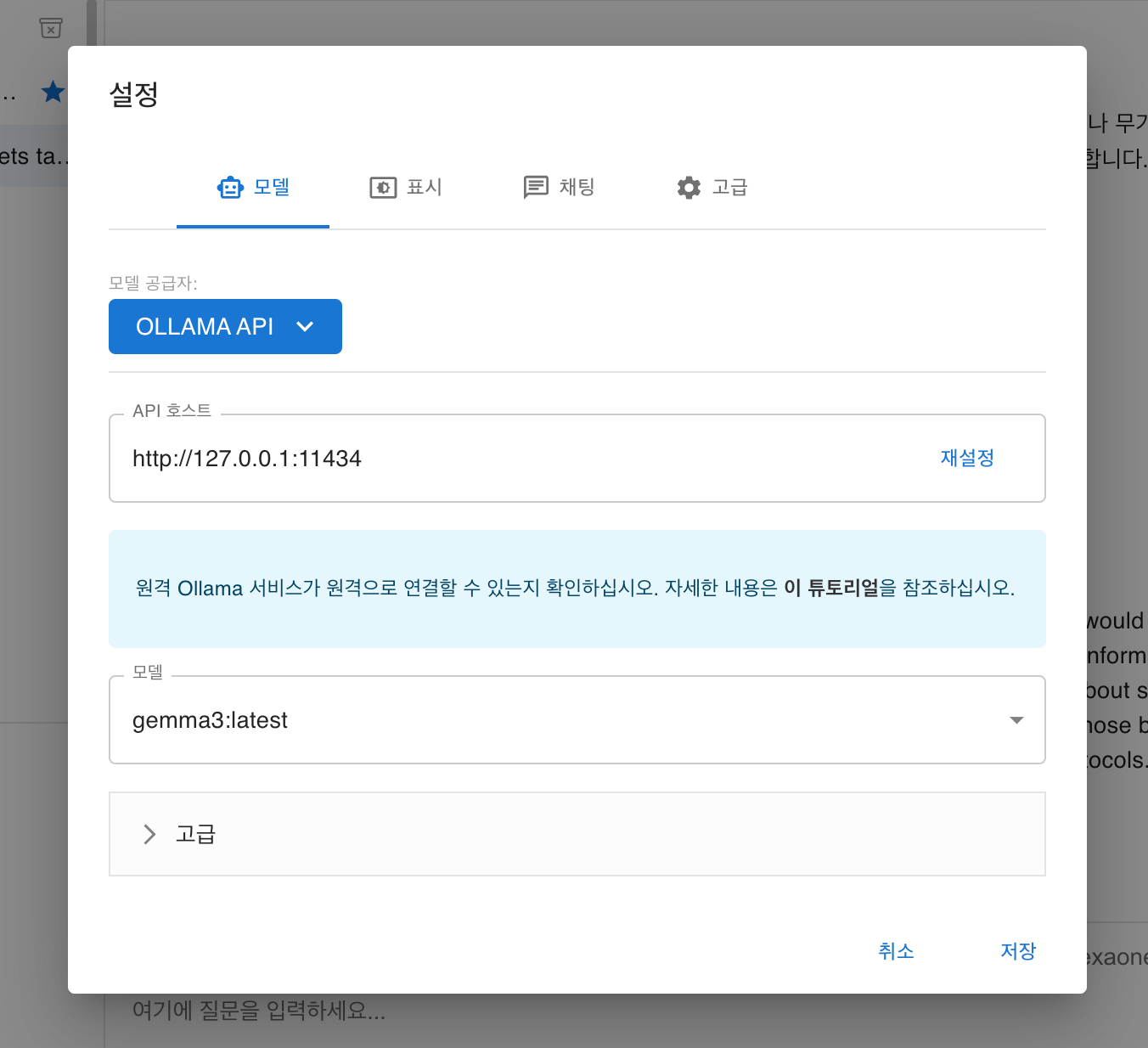

Chatbox 프로그램 내 왼쪽 사이드 메뉴에 있는 [새로운 채팅]을 통해 LLM에게 질의를 하실 수 있습니다.

자, 같은 방식으로 Ollama 에만 다운로드가 완료되면 Chatbox에서는 언제든 모델을 변경해가며 사용할 수 있습니다.

이제 다른 모델도 돌려봅시다!

설치된 모델 조회 명령어 : ollama list

설치된 모델 삭제 명령어 : ollama rm {이미지명}

예) ollama rm gemma3:latest

추천 모델

로컬 추천 모델은 아래와 같습니다.

- Llama 3.2

- Gemma 3

- Gemma 2

- DeepSeek R1

- Phi-4

- Mistral

- Exaone (한국어 추천)

- Exaone deep (한국어 추천)

자 이제 RAG도 해보자

Ollama와 RAG를 활용한 PDF 기반 로컬 챗봇 LLM 만들기

https://god-logger.tistory.com/m/205

Ollama와 RAG를 활용한 PDF 기반 로컬 챗봇 LLM 만들기

Ollama와 RAG를 활용한 PDF 기반 챗봇 개발이번 포스트에서는 Python으로 Ollama와 RAG(검색 증강 생성)를 결합하여 PDF 문서를 기반으로 한 챗봇을 만드는 방법을 소개하겠습니다.전반적인 프로세스

god-logger.tistory.com

'AI 인공지능' 카테고리의 다른 글

| 이미지 생성 유명 모델 Flux.1 dev ( 또는 schnell ) 를 실행해보자. (0) | 2025.04.05 |

|---|---|

| Ollama와 RAG를 활용한 PDF 기반 로컬 챗봇 LLM 만들기 (2) | 2025.03.27 |

| Chatbox vs Open-WebUI : 간편함과 UI 사이에서의 고민 (0) | 2025.03.11 |

| OpenAI Whisper - STT 및 자동 자막 생성 (0) | 2025.02.10 |

본 포스팅은 개발 지식이 없으신 분들을 타겟하여 작성하였습니다.

참고 바랍니다.

코딩 몰라도 괜찮아요!

개발 지식이 없어도, 단계별로 따라 하기만 하면 로컬 PC에서 나만의 인공지능 모델을 실행할 수 있다면 믿으시겠나요?

이번 블로그 글에서는 프로그래밍을 전혀 모르는 분들도 쉽게 따라 할 수 있는 방법으로, Ollama와 Chatbox를 활용해 Gemma 3(4B) 모델을 설치하는 과정을 소개합니다.

복잡한 코드는 잊고, 설치만으로 AI를 경험해보세요!

한번만 따라하시면, 아래 모델들을 PC에 설치하여 돌려보실 수 있습니다.

- Google - Gemma3 / Gemma2 ...

- China - Deekseek-r1

- LG - Exaone / Exaone Deep

- Meta - Llama 3.2 / Llama 3 ...

- Mistral AI - Mistral

- Alibaba - Qwen2.5 ...

로컬에서 LLM(대규모 언어 모델)을 실행하면 웹 기반 AI 서비스와는 다른 매력을 느낄 수 있는데요.

먼저, 두 방식의 차이를 알아보고, 왜 Ollama와 Chatbox를 선택했는지 설명한 뒤 설치 방법을 안내하겠습니다.

웹 기반 LLM vs 로컬 LLM: 어떤 차이가 있을까?

LLM을 사용하는 방식은 크게 두 가지로 나뉩니다.

웹에서 제공되는 서비스(예: ChatGPT)와 로컬 PC에 설치해 사용하는 방식.

이 둘의 차이를 간단히 정리하면 아래와 같습니다.

| 구분 | 웹 기반 LLM | 로컬 LLM |

| 인터넷 연결 | 필수 ( 온라인에서만 동작 ) | 불필요 ( 오프라인 사용 가능 ) |

| 개인 정보 | 입력 데이터 서버 전송, 유출 가능성 | 데이터가 PC에만 저장, 프라이버시 보장 |

| 속도 | 서버 상태나 네트워크의 의존 | PC 성능에 따라 결정 |

| 비용 | 무료 또는 구독료 | 오픈 소스 기준 0원 |

| 사용성 | 로그인 후 사용 | 초기 설치 필요 |

개인 컴퓨터 사양에 따라 사용 가능한 모델이 달라져 품질의 차이는 날 수 밖에 없습니다.

고사양의 컴퓨터 (특히 그래픽카드)에 따라 모델 선택의 폭이 결정되므로, 저사양이라면 이런거구나 정도만 보시고 웹 기반 LLM을 추천할 수 밖에 없죠.

그렇지만 로컬 LLM을 쓰는 부분에 있어 장점은 확실합니다.

인터넷 연결 없이도 동작하며 데이터가 외부로 나가지 않아 민감한 작업에 적합하기에, 큰 기업일수록 회사만의 LLM을 만들어 사내에서만 사용하는 사례가 점차 늘어나고 있고 이에 맞춰 AI 솔루션 회사들도 많이 생겨나고 있습니다.

그런 부분을 간접적으로 경험해보고 이런거구나 정도 알아가는 정도로만 보시는게 좋지, ChatGPT처럼 고퀄리티의 답변을 기대하시면 안됩니다.

왜 Ollama와 Chatbox를 선택했나?

로컬 LLM을 설치할 수 있는 도구는 많지만, 저는 Ollama와 Chatbox를 추천합니다.

이유는 아래와 같습니다.

- 프로그래밍 지식 제로: 복잡한 코드 작성 없이 설치

- 간편한 사용성: Ollama는 모델을 쉽게 다운로드 및 실행역활, Chatbox는 채팅창처럼 편리한 인터페이스를 제공

- 무료 오픈소스: 개인이라면 비용 걱정 없이 누구나 사용 가능

코딩을 몰라도 마우스 클릭과 간단한 명령어만으로 AI를 뚝딱 실행할 수 있다는 점이 이 조합의 최대 강점입니다.

자, 그럼 설치 시작해볼까요?

1. Ollama 설치하기

Ollama는 로컬에서 LLM을 실행하는 핵심 도구입니다.

Ollama 다운로드

- Ollama 공식 웹사이트에 접속하세요.

- 내 운영체제에 맞는 파일을 다운로드합니다

- Windows: .exe 파일

- macOS: .dmg 파일

- Linux: 터미널에 [ curl -fsSL https://ollama.com/install.sh | sh ] 입력.

- 다운로드한 파일을 더블클릭해 설치합니다.

- Ollama를 실행합니다. (실행시 tray아이콘이 표시됩니다)

2. Gemma 3 (4B) 모델 설치하기

모델은 자유롭게 선택하여 설치하셔도 좋지만, 처음이시라면 4B짜리 gemma3 모델로 먼저 설치해보겠습니다.

1) Ollama 공식 웹사이트에서 모델 정보를 확인합니다.

https://ollama.com/search

2) gemma3를 검색하시거나 이미 보이신다면 클릭하여 페이지 내부로 들어갑니다.

3) 왼쪽 셀렉트박스를 4b로 선택하신 후, 복사버튼을 누룹니다.

4) 터미널 ( 명령프롬프트 ) 를 실행하여 붙여넣기를 한 후 엔터를 칩니다.

5) 다운로드가 진행되고 대기합니다.

6) 다운로드가 끝나면 바로 모델에게 질의를 할 수 있습니다만, 터미널에서 하지마시고 일단 창을 끕니다.

ollama list 라는 명령어를 사용했을 때 gemma3:latest가 보이면 성공입니다.

3. Chatbox 설치 및 연결하기

터미널 대신 예쁜 채팅창으로 대화하길 바라므로 Chatbox를 설치하겠습니다.

1) ChatBox 다운로드

- Chatbox 웹사이트에서 운영체제에 맞는 파일을 다운로드

- 설치 파일 실행하여 설치 진행

2) Ollama와 연결

ChatBox를 열고 Settings로 이동 - Settings(설정)에서 아래와 같이 설정 (또는 그림과 같이) - 저장

- 모델 공급자 : OLLAMA API

- API 호스트 : http://127.0.0.1:14434

- 모델 : gemma3:latest

4. 채팅 시도

Chatbox 프로그램 내 왼쪽 사이드 메뉴에 있는 [새로운 채팅]을 통해 LLM에게 질의를 하실 수 있습니다.

자, 같은 방식으로 Ollama 에만 다운로드가 완료되면 Chatbox에서는 언제든 모델을 변경해가며 사용할 수 있습니다.

이제 다른 모델도 돌려봅시다!

설치된 모델 조회 명령어 : ollama list

설치된 모델 삭제 명령어 : ollama rm {이미지명}

예) ollama rm gemma3:latest

추천 모델

로컬 추천 모델은 아래와 같습니다.

- Llama 3.2

- Gemma 3

- Gemma 2

- DeepSeek R1

- Phi-4

- Mistral

- Exaone (한국어 추천)

- Exaone deep (한국어 추천)

자 이제 RAG도 해보자

Ollama와 RAG를 활용한 PDF 기반 로컬 챗봇 LLM 만들기

https://god-logger.tistory.com/m/205

Ollama와 RAG를 활용한 PDF 기반 로컬 챗봇 LLM 만들기

Ollama와 RAG를 활용한 PDF 기반 챗봇 개발이번 포스트에서는 Python으로 Ollama와 RAG(검색 증강 생성)를 결합하여 PDF 문서를 기반으로 한 챗봇을 만드는 방법을 소개하겠습니다.전반적인 프로세스

god-logger.tistory.com

'AI 인공지능' 카테고리의 다른 글

| 이미지 생성 유명 모델 Flux.1 dev ( 또는 schnell ) 를 실행해보자. (0) | 2025.04.05 |

|---|---|

| Ollama와 RAG를 활용한 PDF 기반 로컬 챗봇 LLM 만들기 (2) | 2025.03.27 |

| Chatbox vs Open-WebUI : 간편함과 UI 사이에서의 고민 (0) | 2025.03.11 |

| OpenAI Whisper - STT 및 자동 자막 생성 (0) | 2025.02.10 |